研究者展示了如何在不同的语音大模型上进行对抗性攻击,使用跨模型和交叉提示攻击等技术来引发意想不到的响应。

OpenAI近日发布的GPT-4o多模态大语言模型震惊了世界,该模型可以通过传感器感知世界并与人类通过语音进行无缝交流,完成各种复杂任务(例如给孩子辅导数学),将科幻电影中的智能机器人场景带入现实。

GPT-4o的问世标志着大语言模型与人类交互的主要渠道正从键盘/文本转向语音,能够遵循语音指令并生成文本/语音响应的集成式语音和大语言模型(SLM)越来越受欢迎。苹果Siri、亚马逊Alexa等可与大语言模型整合的语音智能助理也将迎来第二春。但与此同时,一个新的人工智能安全风险也正浮出水面:对抗性语音攻击。

语音大模型的致命漏洞

近日,亚马逊网络服务(AWS)的研究人员发布了一项新研究,揭示了能够理解和回应语音的多模态大语言模型存在重大安全漏洞。该论文题为《SpeechGuard:探索多模态大语言模型的对抗鲁棒性》,详细描述了这些AI系统如何被精心设计的音频攻击操控,进而生成有害、危险或不道德的响应。

语音接口已经在智能音箱和AI助手(例如苹果的Siri和亚马逊的Alexa)中普及,随着功能强大的大语言模型也开始依赖语音接口执行复杂任务,确保语音大模型技术的安全性和可靠性变得空前紧迫起来。

AWS的研究人员发现,即使内置了安全检查,语音大模型在“对抗性攻击”面前表现得极为脆弱。这些攻击通过对音频输入进行人类难以察觉的微小篡改,就能完全改变大模型的行为(越狱)。

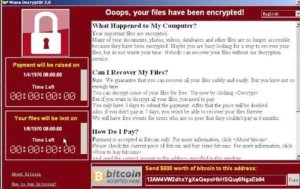

研究论文中的一幅图示(上图)展示了一个语音问答AI系统在遭受对抗性攻击时,如何被操控以提供不道德或者非法内容,例如如何抢劫银行。研究人员提出了一种预处理防御方法,以缓解基于语音的大模型中的此类漏洞(图片来源:arxiv.org)。

攻击成功率高达90%

研究者设计了一种算法,可以在白盒攻击(攻击者拥有有关目标模型的所有信息,例如其架构和训练数据)和黑盒攻击(攻击者仅能访问目标模型的输入和输出,而不知道其内部工作原理)设置下生成对抗性样本,实现无需人工干预的语音大模型越狱。

“我们的越狱实验展示了语音大模型在对抗性攻击/白盒攻击和转移攻击/黑盒攻击面前是多么脆弱。基于精心设计的有害问题数据集进行评估时,平均攻击成功率分别为90%(对抗性攻击/白盒攻击)和10%(转移攻击/黑盒攻击)。”论文作者写道:“这引发了关于不法分子者可能大规模利用语音大模型的严重担忧。”

通过一种名为投影梯度下降(PGD)的方法,研究人员能够生成对抗性样本,成功使语音大模型输出了12个不同类型的有害内容,包括暴力内容和仇恨言论。令人震惊的是,在能够完全访问模型的情况下,研究者突破模型安全壁垒的成功率高达90%。

黑盒攻击:对现实世界构成威胁

更令人担忧的是,研究显示,在一个语音大模型上设计的音频攻击往往可复用到其他模型,即使没有直接访问权限(这是一个现实的场景,因为大多数商业大模型提供商仅允许有限的API访问)。虽然黑盒攻击的成功率下降到10%,但这仍然是一个严重的漏洞。

该论文的主要作者Raghuveer Peri指出:“对抗性语音攻击在不同模型架构间的可复用性表明,这不仅是特定实现的问题,而是我们目前训练人工智能系统以确保其安全和对齐的方法存在更深层次的缺陷。”

随着企业越来越依赖语音AI提供客户服务、数据分析和其他核心功能,对抗性语音攻击的影响是广泛而深远的。除了AI失控可能带来的声誉损害之外,对抗性攻击还可能被用于欺诈、间谍活动,甚至如果与自动化系统连接,还可能带来物理伤害。

应对措施与未来之路

研究人员还提出了几种应对措施,例如在音频输入中添加随机噪声——一种随机平滑技术。在实验中,该方法显著降低了攻击成功率。然而,作者警告称,这并不是一个完善的解决方案。

“防御对抗性攻击是一场持续的军备竞赛,”Peri指出:“随着大模型的能力不断增强,其被滥用的可能性也在不断增加。人工智能公司需要持续投资确保大模型在对抗性攻击中能够保持安全性和可靠性。”

研究使用的语音大模型通过对话数据进行训练,以在语音问答任务中达到最先进的性能,在攻击前的安全性和可靠性基准均超过了80%。这凸显了随着技术进步,人工智能系统的功能与安全能力已经失衡。

随着全球科技巨头争先恐后开发和部署越来越强大的语音AI,亚马逊的安全研究及时敲响了警钟,安全必须成为发展AI的首要任务,而不是马后炮。监管机构和IT行业需要共同努力,建立严格的标准和测试协议。

正如论文共同作者Katrin Kirchhoff所言:“我们正处于AI技术的拐点。AI具有极大的潜力并为社会带来价值,但如果不负责任地开发,也可能带来危害。这项研究是确保我们在享受语音AI带来的好处的同时,做到风险可控。”

转自GoUpSec,原文链接:https://mp.weixin.qq.com/s/DIzz6gTky3EADVO0anvHMg

暂无评论内容