![图片[1]安全114-安全在线-安全壹壹肆-网络安全黄页-网络安全百科黑客利用暴露的云凭证,仅 19 分钟劫持 AI 大模型](https://www.anquan114.com/wp-content/uploads/2024/11/20241105095854656-image.png)

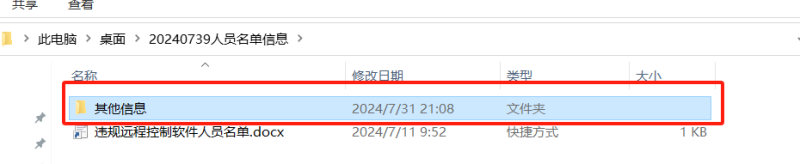

最新研究揭示,网络攻击者正利用暴露的云凭证,快速劫持企业的人工智能(AI)系统。这种攻击方式被称为 LLMjacking,主要针对非人类身份(NHIs),如 API 密钥、服务账户和机器凭证,以绕过传统安全控制并利用被盗的生成式 AI 访问权限进行非法牟利。

安全公司 Entro Labs 的研究发现,攻击者利用自动化的机器人扫描公共代码库和论坛,使用 Python 脚本检测有效凭证。一旦凭证被暴露,攻击者在 9 至 17 分钟内进行初步的 API 调用,如 GetCostAndUsage,以评估账户价值,同时避免使用可预测的调用如 GetCallerIdentity 来逃避检测。

- 凭证收集:自动化的机器人使用 Python 脚本扫描公共代码库和论坛,以检测有效凭证,其中 44% 的非人类身份是通过代码库和协作平台泄露的。

- 快速验证:攻击者在凭证暴露后的 9-17 分钟内执行初始 API 调用(如 GetCostAndUsage)来评估账户价值,并避免使用可预测的调用(如 GetCallerIdentity)以逃避检测。

- 模型枚举:入侵者通过 AWS Bedrock 执行 GetFoundationModelAvailability 请求,以列出可访问的大型语言模型(LLM),包括 Anthropic 的 Claude 和 Amazon Titan,并映射可用的攻击面。

- 漏洞利用:攻击者对受损端点进行自动化的 InvokeModel 尝试,研究人员在实验密钥中观察到每小时超过 1200 次未经授权的推理尝试。

Storm-2139 网络犯罪组织最近利用这种方法攻击了 Microsoft Azure AI 客户,窃取 API 密钥以生成暗网内容。取证日志显示,攻击者:

- 利用 Python 的请求库进行凭证验证

- 使用 aws s3 ls 命令识别 AI/ML 存储桶

- 尝试使用精心设计的提示来绕过内容过滤器的 InvokeModel

Entro 的模拟入侵表明攻击者将自动脚本与手动侦察相结合 ——63% 的初始访问使用 Python SDK,而 37% 使用 Firefox 用户代理通过 AWS 控制台进行交互式探索。

- 成本利用:仅需一个带有 Bedrock 访问权限的受 compromis NHIs,每天可能会产生 46000 美元的未授权推理费用。

- 数据泄露:在 22% 的观察到的事件中,攻击者窃取了模型配置和训练数据元数据。

- 声誉损害:Microsoft Q1 2025 安全漏洞事件中,威胁者利用被盗的 Azure OpenAI 密钥生成了 14000 多张深度伪造图像。

缓解策略

- 检测并实时监控 NHIs

- 实施自动化的秘密轮换

- 强制执行最小权限原则

- 监控不寻常的 API 活动

- 对开发人员进行安全的 NHI 管理教育

随着攻击者在不到 20 分钟内利用漏洞,实时秘密扫描和自动轮换不再是可选的安全措施,而是 LLM 时代的关键生存机制。

消息来源:Cybersecurity News;

本文由 HackerNews.cc 翻译整理,封面来源于网络;

© 版权声明

文章版权归原作者所有,转摘请注明出处。文章内容仅代表作者独立观点,不代表安全壹壹肆&安全114的立场,转载目的在于传递网络空间安全讯息。部分素材来源于网络,如有侵权请联系首页管理员删除。

THE END

暂无评论内容